“In God we trust. All others must bring data”

W. Edwards Deming

Quando, circa 4 mesi fa, ho iniziato a scrivere su Ingenium di “maltrattamenti di dati” pensavo fosse sufficiente ispirarsi alla trilogia di Matrix, ma dopo data mistreatment reloaded e revolutions mi risulta ancora difficile mettere un punto. Potrei ricorrere a saghe più lunghe e articolate, parlare di Data Wars, Data Trek o The Walking Data, ma a questo punto preferisco smarcarmi dai paralleli cinematografici.

Il fatto è che i fake data, come controparte quantitativa e quindi intrinsecamente più autorevole delle fake news, sono ovunque attorno a noi e non escludo di tornare sull’argomento anche in futuro (è una minaccia). Come ho già detto in passato, spesso non sono i dati ad essere fasulli ma i trattamenti a cui sono sottoposti, da cui derivano conclusioni inaffidabili. Per dirla come il premio Nobel dell’economia Ronald Coase “Torture the data, and it will confess to anything“.

Cosa accade però quando la stessa materia prima, i dati appunto, è di scarsa o pessima qualità? E, per peggiorare le cose, cosa può succedere quando su questa materia prima si basa l’attività di vigilanza dell’Autorità Nazionale Anticorruzione (ANAC) in tema di appalti pubblici?

Prolegomeni ad ogni futura verifica di trasparenza: bandi di gara IT della PA

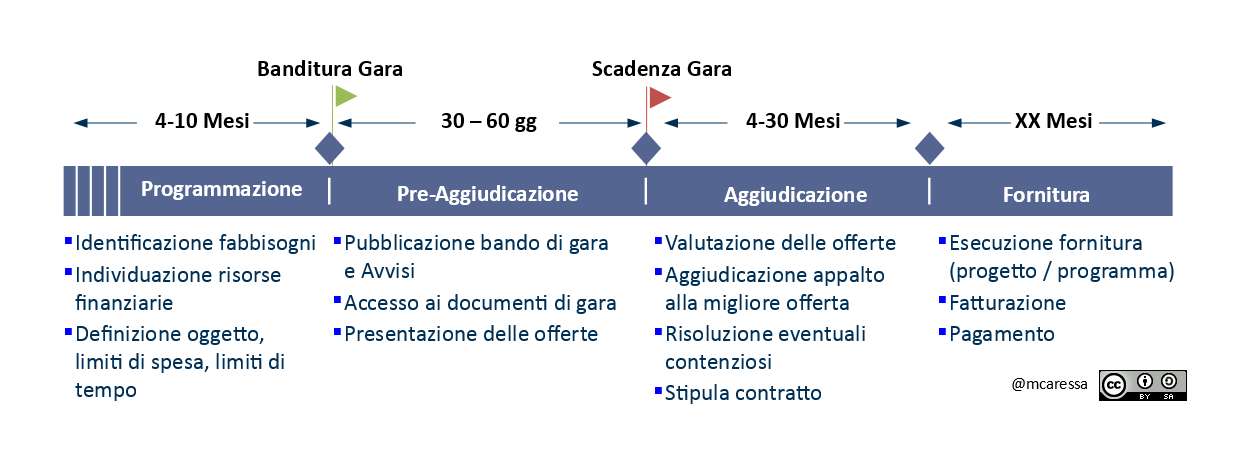

Per capire di quali fake data stiamo parlando devo brevissimamente spiegare come funziona una gara di appalto pubblica IT.

Gli obiettivi di spending review imposti dalla legge di stabilità 2016 prevedevano che la sola PA Centrale tagliasse annualmente la spesa IT di circa 700 milioni di euro nel triennio 2016-2018. Poiché la spesa della PA deve passare per legge da gare di appalto pubbliche, la traiettoria principale di azione da qualche anno a questa parte è consistita nella razionalizzazione e consolidamento della spesa IT attraverso l’analisi e l’aggregazione della domanda da parte di Centrali di Committenza (es. Consip) e tentando di accorciare i tempi dei procedimenti di acquisizione e contrattualizzazione.

Lo schema precedente esemplifica il cosiddetto “IT Procurement”, cioè il processo di acquisizione di beni e servizi IT da parte di una PA. L’aggregazione della domanda determina una concentrazione della spesa in poche grosse gare di appalto (torneremo dopo su questo), che però, nei casi peggiori, impiegano fino a 3-4 anni per passare dall’identificazione dei fabbisogni all’inizio della fornitura che li soddisfi. Tempi poco accettabili per una merce come l’IT, a “rapida obsolescenza”.

Il nuovo codice degli appalti prevede, in ogni caso, che su ogni gara di appalto pubblica ANAC effettui una serie di controlli anticorruzione per garantire la trasparenza del procedimento e la eligibilità dei soggetti economici partecipanti. Questo passaggio è molto importante per intercettare irregolarità e rischi di distorsioni del mercato, assicurando un processo di valutazione equo e trasparente.

Il database degli appalti e la Commissione Parlamentare di Inchiesta

Per ottemperare alla sua missione istituzionale, ANAC si è dotata di un database dove sono censite tutte le gare di appalto e tracciate le informazioni storiche relative al procedimento di valutazione (chi partecipava, chi ha vinto, con quale importo, con quali tempi, etc.) Nella legislatura appena terminata è stata attiva una Commissione Parlamentare di Inchiesta, presieduta dall’On. Paolo Coppola, sul livello di digitalizzazione e innovazione delle PA e sugli investimenti complessivi riguardanti il settore delle tecnologie e della comunicazione.

La relazione finale della Commissione riporta diverse elaborazioni statistiche effettuate sui dati contenuti all’interno del database di ANAC.

Nel paragrafo 3.2 della relazione “Analisi delle gare di appalto” (a partire da pag. 37) si afferma testualmente:

I dati richiesti ad ANAC sono stati inviati alla Commissione a più riprese, poiché più volte essi risultavano non allineati o imprecisi e di conseguenza inutilizzabili. La mancanza di un formato adatto all’elaborazione del dataset ha costretto la Commissione ad attendere che quest’ultimo venisse estratto in un formato elaborabile. Inoltre, le frequenti anomalie rilevate sui dati estratti, hanno reso necessario un lungo lavoro di ripulitura del dataset. Le anomalie riscontrate sui dati hanno avuto un carattere sia sintattico che semantico… [omissis]…

…Il lavoro di pulizia del dataset è stato svolto in stretta collaborazione con ANAC e ha visto produrre cinque diverse estrazioni dei dati, che hanno così permesso di giungere a quella che è poi stata considerata la versione finale…[omissis]…

…La Commissione non ritiene che le operazioni preliminari sul dataset ne abbiano aumentato la qualità ad un livello sufficiente. Le analisi di questo capitolo vanno considerate come esempio di cosa sarebbe possibile fare se solo il processo di raccolta dei dati ne assicurasse la qualità. Gli esempi di incongruenze presenti in questo capitolo servono a mettere in evidenza il livello e la tipologia di errori presenti nel dataset.

Insomma, la Commissione ha dichiarato che quello delle gare di appalto di ANAC è un fake-database, con molteplici falle e incongruenze, oltre a una sensibile quantità di dati sporchi e inattendibili; ciò che rende qualsiasi elaborazione di quei dati un mero esercizio di stile senza alcuna validità statistica. La Commissione ha presentato comunque, nel Capitolo 3 della relazione, una cospicua serie di analytics elaborati a partire dai dati di ANAC ma avverte, appunto, che questo va considerato solo come “esempio di ciò che si potrebbe fare“.

E che sarebbe il caso di fare per davvero, aggiungo. Tanto per fare un esempio, il database ANAC rilevava 302 gare di appalto dove la data di aggiudicazione risultava antecedente alla data di banditura. Ora, delle due l’una: o stiamo certificando macroscopiche irregolarità (di cui forse dovrebbero essere interessate le Procure), oppure le procedure di alimentazione e controllo della qualità dei dati sono stati progettate/condotte in maniera decisamente insufficiente.

Non serve essere esperti di data extraction, transformation & loading o data scientist per concludere che, allo stato attuale, la funzione di monitoraggio e controllo dell’Autorità Nazionale è attualmente compromessa e che andrebbe subito avviato un progetto di revisione e, probabilmente, di riprogettazione del database delle gare di appalto.

Tra l’altro anche lo sforzo della Commissione Parlamentare, pur lodevole e con le premesse di cui sopra, mostra alcune carenze di metodo. Ad esempio, secondo la relazione la durata media di una gara di appalto, dalla banditura all’aggiudicazione, è pari a 63 giorni, calcolata però come media aritmetica delle durate di 35.000 gare, da quelle microscopiche da poche migliaia di euro alle grosse convenzioni nazionali Consip da centinaia di milioni di euro.

Una gara di importo maggiore, più grande e complessa, è logico che duri di più, ma la progressiva concentrazione degli appalti tramite le centrali di acquisto fa si che il grosso della spesa IT si giochi su pochissimi grandi appalti, la cui durata è bel al di sopra del valore medio aritmetico.

Inoltre, i 63 giorni sono relativi alle due fasi di “pre-aggiudicazione” e “aggiudicazione” dello schema di processo precedente, ma contenziosi e ricorsi (spesso temerari a causa del basso costo economico per appellarsi al TAR) dilatano i tempi di mesi quando non di anni.

Conclusioni

Sul data mistreatment non bisogna assolutamente abbassare la guardia, soprattutto in relazione ai dati utilizzati per verificare la spesa pubblica. Pur valutando positivamente l’attività della Commissione Parlamentare sulla digitalizzazione della PA, abbiamo la conferma che c’è ancora molto lavoro da fare.

Sarebbe auspicabile la formazione di una Commissione Parlamentare di Inchiesta in continuità con quella della legislatura precedente, per continuare a monitorare il progresso della digitalizzazione del nostro Paese e della nostra PA in particolare. Tema che, purtroppo, non risulta molto presente nei programmi di tutte le forze politiche attualmente in lizza.

Il nuovo codice degli appalti stabilisce regole e procedimenti per uno svolgimento efficace e trasparente dei procedimenti di approvvigionamento di beni e servizi della PA. L’ANAC, per svolgere con efficacia la sua missione istituzionale, deve dotarsi il prima possibile di un sistema informativo e di un relativo sistema informatico (i due concetti, come sappiamo, sono diversi) che sia minimamente consistente, affidabile, sicuro e interoperabile, per elaborare a fini statistici e strategici tutti i dati delle gare di appalto, sia gestite dalle Centrali di Committenza come Consip, sia dalle stesse PA contraenti.

Dati ben raccolti, validi, aperti e correttamente elaborati significano maggiore efficienza della spesa pubblica IT, per cercare nel 2018 di scalare la classifica dell’indice di maturità digitale sociale ed economica DESI che da 2 anni vede il nostro Paese al 25-esimo posto su 28 Paesi europei e cancellare così quella brutta frase oggi presente in home page “Romania, Bulgaria, Greece and Italy have the lowest scores“.

Facebook Comments