Nel mese di giugno del 2018 la Commissione Europea ha individuato un gruppo di 52 esperti, provenienti dal mondo accademico, dell’industria e della società civile, con l’obiettivo di supportare l’implementazione della strategia europea sull’intelligenza artificiale.

Lo scorso 18 dicembre, attraverso la European AI Alliance, è stata pubblicata la bozza conclusiva delle linee guida etiche da utilizzare in Europa per la progettazione, lo sviluppo e l’uso di applicazioni di intelligenza artificiale. Tale bozza è stata aperta per un mese a commenti e suggerimenti volti al suo miglioramento, in modo da emettere la versione definitiva entro marzo 2019.

Nel’executive summary del documento si afferma che “l’intelligenza artificiale ha la capacità di generare eccezionali benefici per gli individui e per la società, ma allo stesso tempo pone rischi che devono essere opportunamente gestiti. Nel complesso, i benefici superano i rischi e per questo dobbiamo seguire la strada che consenta di massimizzare i benefici e di minimizzare i rischi. Per non deviare da questa direzione, è necessario adottare un approccio umano-centrico all’intelligenza artificiale, costringendoci a tenere a mente che lo sviluppo e l’uso dell’intelligenza artificiale non deve essere visto come un mezzo in sé, ma come qualcosa che ha l’obiettivo di incrementare il benessere dell’umanità”.

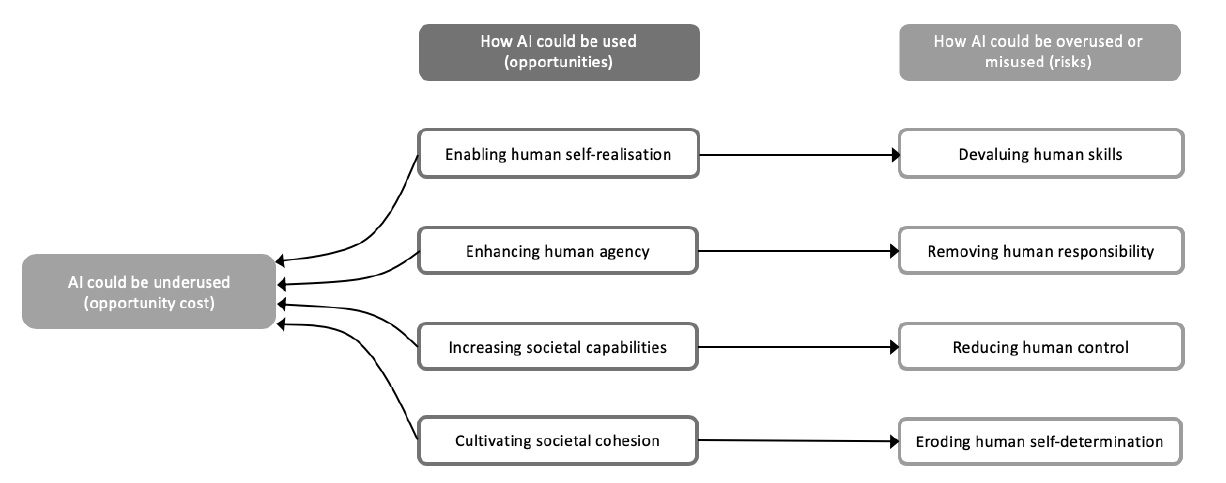

Siamo quindi in presenza di un atteggiamento decisamente positivo, ben descritto in un precedente documento prodotto dall’iniziativa AI4People, nata allo scopo di individuare i principi, le politiche e le pratiche utili a realizzare una “good AI society”, di cui il codice etico riprende l’impostazione. In esso venivano individuate le opportunità che l’intelligenza artificiale offre, in riferimento ai quattro punti fondamentali che promuovono la dignità umana: l’auto-realizzazione (chi possiamo divenire), l’agire umano (cosa possiamo fare), le capacità individuali e sociali (cosa possiamo ottenere) e la coesione sociale (come interagiamo con gli altri e con il mondo). A ciascuna opportunità corrisponde però un rischio legato ad un utilizzo eccessivo o improprio di queste potenzialità mentre, in generale, si evidenzia come un sotto utilizzo dell’intelligenza artificiale può generare dei costi opportunità.

Sempre nell’executive summary delle linee guida etiche si afferma che “la stella polare deve essere un’intelligenza artificiale affidabile, perché l’essere umano sarà capace di cogliere pienamente e con fiducia tali benefici solo se si fiderà della tecnologia.”

E’ pertanto opportuno riportare cosa il documento intende per intelligenza artificiale affidabile (trustworthy AI) e per etica dell’intelligenza artificiale (role of ethical AI).

“La fiducia è un prerequisito per le persone e per la società per sviluppare, rilasciare ed utilizzare l’intelligenza artificiale. L’assenza di una dimostrazione che l’intelligenza artificiale sia pienamente affidabile può far scaturire conseguenze sovversive e ostacolare la sua adozione, con il risultato di pregiudicare la realizzazione degli ampi benefici economici e sociali che essa è capace di promuovere.” … “La fiducia nell’intelligenza artificiale comprende la fiducia nella tecnologia, su come è costruita ed è utilizzata dall’essere umano; fiducia nelle regole, nelle leggi e norme che regolano l’intelligenza artificiale …, o fiducia nei modelli di business e di governo pubblico dei servizi, dei prodotti e dei produttori di intelligenza artificiale”.

Circa il ruolo dell’etica nell’intelligenza artificiale, si afferma che “l’etica è un campo di studio millenario che cerca di rispondere a domande come “qual è una buona azione”, “cos’è giusto” e, in qualche caso, “qual è una buona vita”. L’etica dell’intelligenza artificiale rappresenta un sotto-insieme di questa ricerca e ha a che fare con l’etica applicata e la tecnologia, occupandosi delle sfide etiche poste dalla progettazione, dallo sviluppo, dall’implementazione e dall’uso dell’intelligenza artificiale. L’obiettivo dell’etica dell’intelligenza artificiale è quello di identificare come essa può promuovere la “buona vita” delle persone, o anche di come può destare preoccupazioni, in termini di qualità della vita stessa, di autonomia di pensiero o di libertà di vivere in una società democratica. Essa si preoccupa sia di problemi legati alla diversità e all’inclusione (con riferimento ai dati di apprendimento dell’intelligenza artificiale ed alle sue finalità), sia dei problemi di giustizia distributiva (chi beneficia dell’intelligenza artificiale e chi no).”

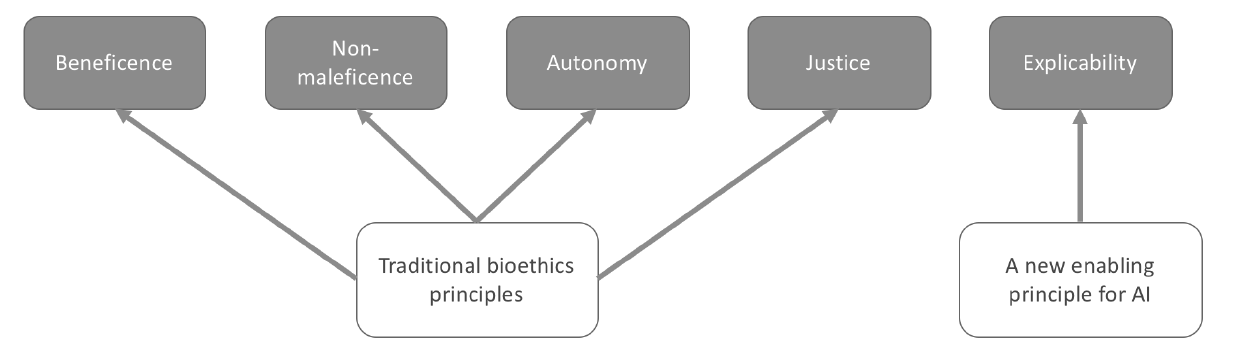

Le linee guida etiche individuano cinque principi di base che devono sorreggere lo sviluppo e la diffusione dell’intelligenza artificiale. Ai tradizionali quattro principi della bioetica, ovvero il fare del bene (beneficence), il non fare del male (non-malefiecience), l’autonomia (autonomy) e la giustizia (justice), se ne aggiunge uno specifico, quello della “esplicabilità” (explicability). Quest’ultimo è stato inserito poiché l’intelligenza artificiale agisce come agente esterno e quindi è necessario che essa operi in modo trasparente, sia nello spiegarne il funzionamento (principio di intellegibilità), sia nel chiarire chi è responsabile del suo funzionamento, il che include anche la comprensibilità del suo risultato.

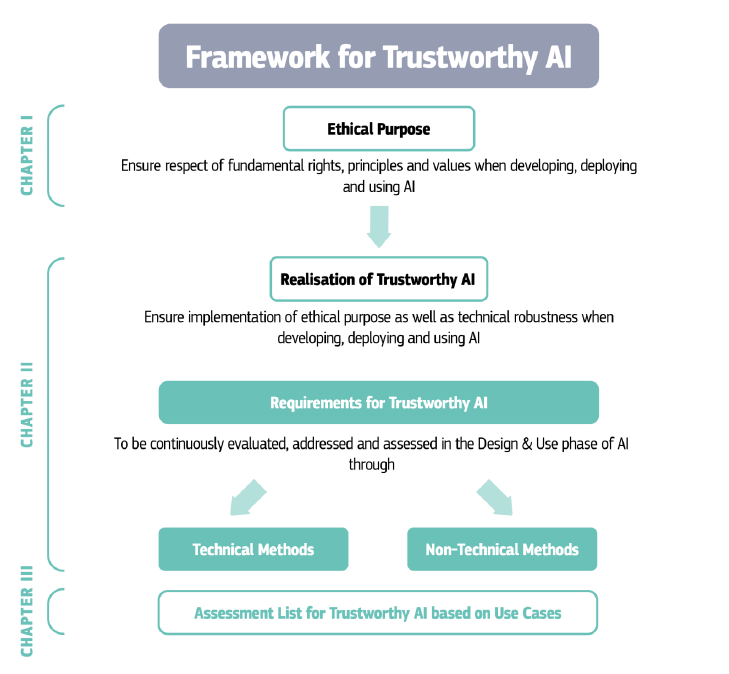

Ma il documento non si prefigge solo lo scopo di elencare i diritti fondamentali e i corrispondenti principi e valori alla base di un approccio etico, come fa nel primo capitolo, ma quello di fornire linee guida per lo sviluppo e l’operatività delle applicazioni di intelligenza artificiale, tramite la definizione di un framework completo.

Pertanto, al primo capitolo ne segue un secondo che, dopo aver individuato i dieci requisiti necessari per rendere applicativi i principi etici di base, propone metodi sia tecnici che non tecnici a supporto dello sviluppo e dell’implementazione di applicazioni di intelligenza artificiale affidabili.

Fonte: Draft Ethics guidelines for trustworthy AI

I dieci requisiti sono la responsabilità (accountability), la data governance, la progettazione inclusiva (design for all), aperta ad ogni categoria sociale, che include i requisiti di usabilità ed accessibilità, il governo dell’autonomia dell’intelligenza artificiale, la non discriminazione, il rispetto (ed il potenziamento) dell’autonomia umana, il rispetto della privacy, la robustezza, la sicurezza e la trasparenza.

Il terzo capitolo, infine, propone una lista di controllo, in forma di un set di domande o di indicazioni per ciascuno dei dieci requisiti di cui sopra, a supporto della verifica di operatività delle applicazioni di intelligenza artificiale.

Nel documento è centrale il ruolo della dignità umana. L’intelligenza artificiale non dovrà mai danneggiare l’essere umano (ma il concetto si estende anche all’ambiente ed agli animali) e dovrà proteggerne l’integrità fisica e morale, l’identità personale e culturale e la soddisfazione dei bisogni essenziali. Centrale è anche il rispetto della libertà individuale, al pari di quello della democrazia, della giustizia e del ruolo delle leggi. Ulteriori punti di riferimento sono l’eguaglianza, la non-discriminazione e la solidarietà, oltre al rispetto del diritto di cittadinanza. Centrale anche il concetto dell’autonomia umana, poiché le macchine intelligenti dovranno sempre operare in favore della realizzazione dell’autonomia dell’uomo, mai riducendola. È indispensabile inoltre che i meccanismi di funzionamento di questi dispositivi siano trasparenti, accessibili e in linea di principio comprensibili a tutti.

Il documento affronta alcuni casi concreti e qui il gruppo di esperti che lo ha redatto ha individuato alcune zone grigie di applicazione per le quali non è stato raggiunto un pieno consenso su cosa deve e può essere fatto e su cosa non deve essere fatto con l’intelligenza artificiale. Ad esempio, non si potranno identificare singoli individui, o raccogliere dati su di loro o sul loro comportamento senza il loro consenso, ma per questo sarà necessario sviluppare nuovi sistemi di identificazione per adeguarsi ai diversi e sofisticati sistemi di rilevazione automatica. Si dovrà fare attenzione allo sviluppo di sistemi di intelligenza artificiale occulti (si va da una realistica affermazione che ogni essere umano deve essere reso consapevole quando interagisce con un’applicazione di intelligenza artificiale, ad una più futuribile – e forse fantascientifica minaccia – di sviluppo di entità androidi). Si entra nel merito anche di applicazioni che assegnano un punteggio sociale che, se esistenti in contesti specifici (ad esempio nel caso delle patenti a punti), devono essere evitate su larga scala come nel caso di punteggi sociali assegnati dai Governi ai cittadini o in situazioni in cui si verifica un’evidente asimmetria di potere tra le parti. Altri aspetti critici o controversi riguardano l’attuale ricerca nello sviluppo di armi letali che possano colpire in modo selettivo e senza intervento umano, oppure la ricerca nello sviluppo di intelligenze artificiali provviste di coscienza artificiale, anche se viene ammesso che si tratta di scenari ancora molto distanti nel tempo.

L’approccio UE diverso da quello di altri Paesi

L’Unione Europea è sempre stata in prima fila per la definizione di regole che hanno l’obiettivo di preservare i diritti e l’integrità dell’uomo: si pensi ad esempio alla disciplina circa le emissioni di gas nocivi da parte dei veicoli, o alle recenti norme GDRP sulla protezione dei dati personali. E’ un vantaggio storico e culturale che l’Europa conferma anche con questa iniziativa. Un atteggiamento che è opportuno venga mantenuto e incentivato nel tempo sia per la sua valenza etica, sia per contrastare l’influenza di sviluppi spesso senza regole di chi sul settore ha già puntato da molto tempo, in primis Usa e Cina.

Paesi diversi mettono in campo culture diverse per affrontare le grandi sfide provenienti dalle nuove tecnologie e dal loro utilizzo. Il caso limite è la Cina dove la collettività viene prima dell’individuo e di conseguenza l’intelligenza artificiale non viene vista come strumento di miglioramento della vita sociale ed individuale, ma come mezzo di governo della società. Si pensi alla sperimentazione in atto su sistemi di riconoscimento facciale utilizzati per catalogare il comportamento degli individui nella vita di tutti i giorni e per assegnare a ciascuno un punteggio sociale che potrà essere utilizzato per decisioni riguardanti la loro stessa vita, come la concessione di un prestito o l’assegnazione di un posto di lavoro, attività che, come abbiamo visto, è stata preventivamente esclusa dalle linee guida etiche Europee.

Con questa iniziativa l’Europa promuove valori come il rispetto della dignità umana, la democrazia, l’uguaglianza, la giustizia, all’interno di un dibattito pubblico aperto, investendo in una cultura volta all’uso responsabile delle nuove tecnologie. E lo fa in modo responsabile, ad esempio quando dichiara nelle premesse del documento che benché esso affronti il problema posto dall’intelligenza artificiale in generale, deve essere tenuto presente che “diverse situazioni chiedono di affrontare sfide diverse” e che data la forte dipendenza dell’intelligenza artificiale dal contesto in cui viene applicata, “è sempre necessario adottare un approccio su misura”. Oppure quando afferma che il documento deve essere mantenuto vivo, con periodici aggiornamenti volti a recepire l’avanzamento della tecnologia e delle conoscenze.

In definitiva, è questo un modo per non rifiutare alcuna innovazione basata sull’intelligenza artificiale, per non rischiare di perdere le molte opportunità che essa ci può consentire di cogliere, senza mettere a rischio i diritti individuali ed i valori sociali. E se questo non potrà funzionare a livello globale, sarà almeno un modo per “porre dei paletti”, per dire alle “multinazionali del digitale”, una volta tanto con un atteggiamento positivo: “queste sono le regole e così si deve fare a casa nostra”. Il documento, infatti, si rivolge a tutti i soggetti che vorranno operare in Europa e che si auspica vengano costretti ad attenersi alle linee tracciate dal documento.

Ma questo è anche un modo per andare oltre il mero rispetto delle regole. Una strategia volta a cogliere le opportunità che il futuro ci prospetta, a guardare avanti con senso della storia e della responsabilità, è una strategia che rispetta le regole e che, allo stesso tempo, supportata da un’opportuna valutazione e gestione dei rischi, sa fare anche qualcosa in più, qualcosa di meglio. Fare quanto è fattibile, fare quanto necessario ed opportuno, sempre con attenzione all’accettabilità sociale e a quanto è socialmente preferibile. E’ questo forse lo scopo di queste linee guida di riferimento che si prospetta saranno mantenute in costante aggiornamento.

Ma cosa ci prospetta veramente il futuro?

L’intelligenza artificiale potrà essere uno strumento volto al bene dell’umanità, capace di liberare un potenziale indirizzato a farla prosperare nel rispetto dei diritti umani, o sarà un mezzo utilizzato per aumentare ulteriormente le disuguaglianze?

Non è possibile dare una risposta ed è probabile che lo sviluppo e l’utilizzo della tecnologia sia portato inevitabilmente a seguire le tendenze politiche in atto sia a livello europeo che mondiale. Ma in questo momento, in cui siamo appena agli inizi di una trasformazione della vita umana che si espliciterà in questo secolo, mentre ci troviamo in una fase di passaggio carica di insidie, è veramente opportuno che l’Europa si faccia promotrice di un’iniziativa che pone le basi perché questo futuro sia progettato e non subito. E’ necessario che la trasformazione digitale in atto non sia percepita come una mera opportunità di beneficiare dall’uso di nuove tecnologie, ma venga colta come un’occasione per rigenerare la cultura umana, con la percezione che il digitale ha creato nuovi spazi comuni dove gli esseri umani, la tecnologia e l’ambiente interagiscono con nuove potenzialità e con la consapevolezza che questi spazi devono essere regolati dalle leggi naturali e sociali, nel rispetto dei diritti umani.

Facebook Comments