I sistemi di intelligenza artificiale stanno raggiungendo livelli di ragionamento pari a quelli degli esseri umani: non si limitano a calcolare le probabilità di successo di una soluzione, ma apprendono e pensano come gli esseri umani. Ciò è certamente affascinante, ma lo sfruttamento di queste tecnologie comporta rischi che non sono stati ad oggi sufficientemente valutati.

In un dibattito organizzato di recente dall’Associazione italiana a sostegno della crescita dell’Internet of Things, IoTItaly, si sono affrontate le criticità dei sistemi di intelligenza artificiale. Non c’è dubbio che l’intelligenza artificiale può essere un supporto enorme in qualsiasi campo, ma deve semplicemente accumulare informazioni e sulla base di queste informazioni definire la soluzione più probabile tramite un calcolo delle probabilità? O deve andare oltre questa tipologia di ragionamento e aggiungere caratteristiche che sono più umane come la capacità di apprendimento e l’intuito?

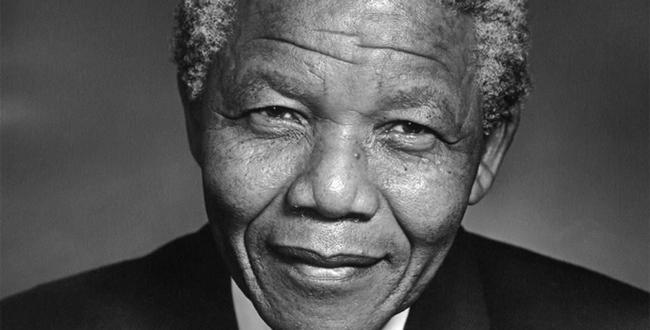

Questo video cerca di illustrare il funzionamento del sistema di intelligenza di Google denominato DeepMind e rende davvero bene l’idea. Come accennato nel video, l’evento che viene considerato “storico” nell’evoluzione dei sistemi di intelligenza artificiale è la vittoria del sistema di intelligenza artificiale AlphaGo contro un maestro dell’antico gioco cinese Go. Il gioco del Go ha molte più varianti degli scacchi e non è quindi possibile considerare tutte le possibili alternative e il sistema deve sviluppare una sorta di “intuito” per definire la strategia migliore.

DeepMind è l’evoluzione di AlphaGo. Infatti, è definito sul suo sito web come leader mondiale nella ricerca dell’intelligenza artificiale e nella sua applicazione per un impatto positivo. Siamo in una missione scientifica per spingere i confini dell’intelligenza artificiale, sviluppando programmi che possono imparare a risolvere qualsiasi problema complesso senza bisogno che gli venga insegnato come fare.

Il sistema di intelligenza artificiale non riceve istruzioni, ma “impara” come fare le cose e comincia a pensare come gli esseri umani. Questo è davvero impressionante poiché il livello di comprensione delle situazioni raggiungibili dai sistemi di intelligenza artificiale è illimitato e ciò vuol dire che il divario tra gli esseri umani e le macchine sta scomparendo.

Quali problemi legali possono derivare dalle “libere” decisioni dell’intelligenza artificiale?

Se i sistemi di intelligenza artificiale sono lasciati liberi di prendere le proprie decisioni, vengono presentati alcuni problemi giuridici “inattesi”:

Chi è responsabile per i sistemi di intelligenza artificiale?

Il Comitato per gli affari legali del Parlamento europeo ha approvato un report che invita la Commissione europea a introdurre una serie di regole sulla robotica. Il Comitato richiede l’introduzione di regole di responsabilità oggettiva ( per esempio del produttore o del proprietario) per i danni causati da sistemi di robotica a causa della difficoltà di determinare il legale tra il comportamento dannoso del robot e il danno subito dal danneggiato. Ma cosa succede in caso di sistemi come Google DeepMind a cui non vengono date indicazioni su cosa fare, ma la macchina semplicemente “impara” a compiere delle attività ed è quindi incontrollabile? I sistemi assicurativi obbligatori possono essere la soluzione, ma questo aggiungerà un ulteriore livello di costi che potrebbe limitare la crescita di queste tecnologie.

L’intelligenza artificiale agisce eticamente?

La scelta che la macchina considera migliore potrebbe non essere la scelta più etica. Ma questo significa che l’intelligenza artificiale non può essere lasciata “libera” di prendere le proprie decisioni?Alcune aziende stanno già istituendo comitati etici per definire i principi da imporre alle macchine. Ciò potrebbe significare che i sistemi di intelligenza artificiale potrebbero:

- “imparare” ad agire anche eticamente;

- avere le proprie decisioni riesaminate da un essere umano come avviene nel settore medico;

- essere utilizzate in maniera completamente libera solo in contesti in cui non è possibile causare danni all’uomo.

E’ possibile giustificare la decisione dell’intelligenza artificiale?

Ai sensi del regolamento europeo sulla protezione dei dati personali, gli individui devono essere in grado di opporsi alle decisioni adottate da sistemi automatizzati che – in caso di dati relativi alla salute – possono essere utilizzati solo con il loro consenso.

Cosa succede se la revisione manuale di una situazione non è in grado di ottenere una piena comprensione del ragionamento eseguito dalla macchina? I ragionamenti che i sistemi di intelligenza artificiale saranno in grado di compiere diventeranno sempre più complessi e questo è un rischio concreto.

Questi sono solo alcune delle implicazioni legali dell’intelligenza artificiale che è certamente un campo estremamente affascinante che porterà senza dubbio a possibili contenziosi.

Facebook Comments