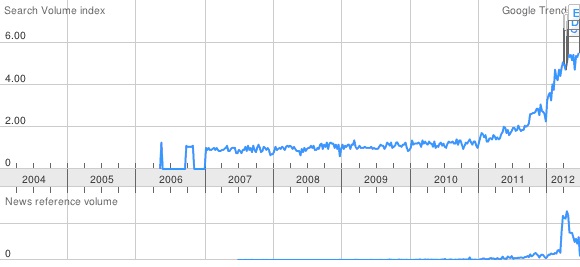

Facendo un rapido giro in internet per cercare di capire qualcosa sul fenomeno Big Data o per cercare risposte alle solite domande su cosa significa, a chi servono e come funzionano, riusciremo sicuramente a trovare un elevato numero di articoli. L’interesse in effetti è in continua e costante crescita, come vediamo anche da una analisi di Google trends sulle ricerche effettuate sul tema.

Nella maggior parte dei casi negli articoli si cercherà però di concentrare l’attenzione sul tema dei dati che aumentano e variano “sempre più” velocemente e sono “sempre più” differenziati, con dotte digressioni sul numero di peta e zetta byte che vengono immagazzinati ogni mattina dagli utenti di Facebook e sopratutto su improbabili esempi per capire quanto alta debba essere la pila di floppy disk che dovremmo impilare per contenerli proprio tutti questi Big Data. A questo punto gli articoli avranno ottenuto l’effetto voluto rendendo i lettori abbastanza impressionati da pensare che in effetti questi dati “sembrerebbero proprio BIg….” concentrando la loro attenzione sul contenuto di tecnologia necessario per affrontare il fenomeno piuttosto che sugli aspetti organizzativi ad esso collegati.

E’ innegabile (ed ora finalmente ci adeguiamo all’andamento tipico degli articoli su questo tema) che la diminuzione dei costi e la facilità di immagazzinamento dei dati, insieme con l’aumento dell’attività social su internet e con l’incremento del numero di dispositivi che producono informazioni, abbia moltiplicato la crescita dei dati ben oltre quanto previsto dalla legge di Moore (che in realtà era nata per la misurare la capacità di elaborazione di un microchip e non il volume delle informazioni).

Ma qual’è il limite oltre il quale i dati diventano Big? E’ preferibilie non fissare una soglia relativa al un volume di un dataset e ci possiamo attenere alla visione secondo la quale la definizione comprende gli archivi talmente complessi da non permettere l’utilizzo delle tecnologie standard di gestione dei database. La complessità infatti si manifesta non solo nel volume ma anche nella mancanza di quella struttura sempre presente alla base dei database o nella presenza di numerose fonti differenti.

A questo punto bisogna tenere in considerazione che le informazioni oltre ad essere numerose hanno anche un ciclo di vita molto più ridotto rispetto a quello a cui siamo abituati (ad esemprio la permanenza di commenti in stato attuale su applicativi social). La conseguenza è che affinchè queste informazioni siano adeguatamente sfruttate ci vogliono tempi di reazione, e di conseguenza di decisione, molto rapidi. E’ utile ricordare che in fondo il tutto nasce, come abbiamo visto negli articoli precedenti, dalla necessità di portare alle persone giuste (chi decide) le informazioni giuste al momento giusto: diminuendo il valore aggiunto del dato molto rapidamente con il passare del tempo la catena tra estrazione delle informazioni, elaborazione e presentazione deve essere necessariamente corta per non perdere tutto il vantaggio derivante dalla manipolazione di questi volumi di dati.

Oltretutto, e qui si ritorna al punto che di solito non viene evidenziato ma che è fondamentale per sfruttare al meglio il valore di queste informazioni: le persone che hanno in mano le leve decisionali devono avere una flessibilità ancora maggiore rispetto a quella, già di per se elevata, necessaria per gestire un normale processo di BI in una struttura perfettamente integrata. Gli impatti dell’evoluzione tecnologica sull’organizzazione di una azienda di solito sono lo scoglio più grosso da superare e difficilmente permetteranno al fenomeno Big Data di procedere con il passo tenuto finora..

Nel prossimo articolo vedremo altri aspetti interessanti sul mondo del Big Data.

Facebook Comments