Nel precedente articolo abbiamo spiegato che i Big Data possono essere definiti in maniera molto generica come un insieme di informazioni che va oltre le capacità di gestione, storage e e analisi della tecnologia attuale, sia in riferimento ai volumi che alla varietà delle fonti. Visto in quest’ottica sembrerebbe che il fenomeno possa essere ridotto ad un problema gestibile esclusivamente con incrementi di performance degli strumenti di BI già disponibili, lavorando quindi sull’aspetto tecnologico, tralasciando quello strutturale.

Questo mondo, invece, presenta aspetti che hanno richiesto un ripensamento delle logiche di analisi per poter sfruttare il valore delle informazioni a disposizione.

Il primo scoglio che si incontra è la disponibilità dei dati presenti in formati differenti su applicativi differenti e con tempi di aggiornamento differenti: è già un bel salto dover fare delle valutazioni su insiemi di questo tipo piuttosto che lavorare con una base dati più o meno omogenea, normalmente definita “strutturata”. Le informazioni a disposizione in realtà complesse ad una prima vista appaiono destrutturate: possiamo però vedere come ognuno dei contenitori che compongono queste realtà siano coerenti e strutturati al loro interno. Per questo motivo probabilmente è più corretto definire questi insieme come multistrutturati. Ai fini della complessità del sistema non cambia molto, ma almeno da la sensazione che un po di ordine da qualche parte sia nascosto…

Il primo scoglio che si incontra è la disponibilità dei dati presenti in formati differenti su applicativi differenti e con tempi di aggiornamento differenti: è già un bel salto dover fare delle valutazioni su insiemi di questo tipo piuttosto che lavorare con una base dati più o meno omogenea, normalmente definita “strutturata”. Le informazioni a disposizione in realtà complesse ad una prima vista appaiono destrutturate: possiamo però vedere come ognuno dei contenitori che compongono queste realtà siano coerenti e strutturati al loro interno. Per questo motivo probabilmente è più corretto definire questi insieme come multistrutturati. Ai fini della complessità del sistema non cambia molto, ma almeno da la sensazione che un po di ordine da qualche parte sia nascosto…

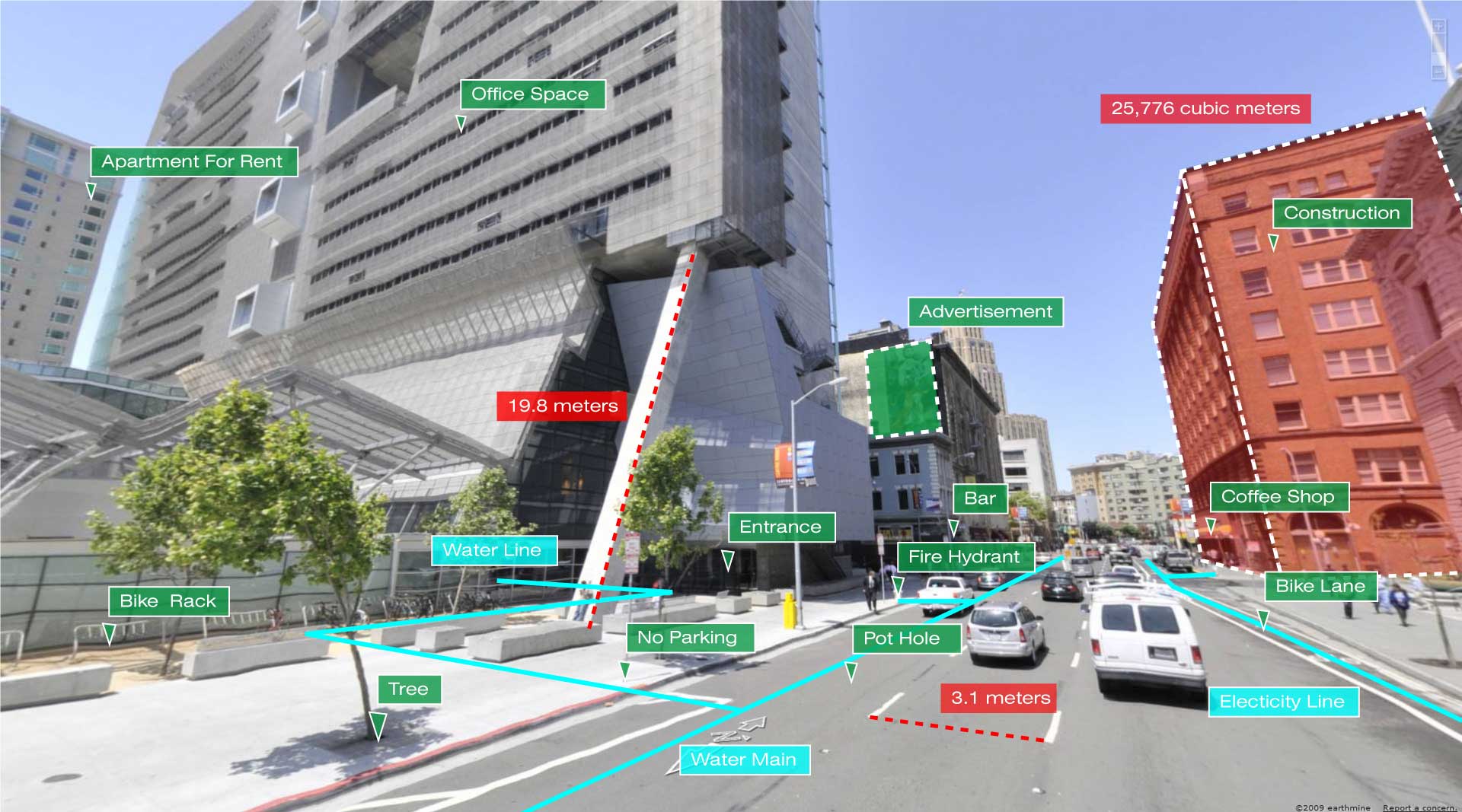

Il secondo scoglio è sicuramente la tempistica con cui variano le informazioni sulle quali si tenta di fare una analisi e prendere di conseguenza una decisione. Si parla di informazioni che nascono o variano in real time, permettendo alle compagnie di fornire prodotti praticamente allineati alle esigenze istantanee del cliente. Un servizio che sfrutta le informazioni di geolocalizzazione di un utente potrebbe ad esempio proporre prodotti ad hoc piuttosto che pricing personalizzati sulla base del passaggio o meno in una determinata zona della città o in un particolare punto del centro commerciale.

Un’altra casistica interessante è la possibilità di estendere la predittività con soluzioni del tipo “best next action” (applicabili anche ad una BI che lavora su dati del giorno precedente) ad ambienti in cui le condizioni variano invece rapidamente. Si tratta di valutare le possibilità a disposizione del cliente in un momento di necessità e proporre la soluzione che massimizza gli interessi del cliente stesso e dell’azienda. Le aziende telefoniche potrebbero essere quelle maggiormente indiziate e ricevere benefici tramite l’utilizzo di queste soluzioni.

Un ultimo scoglio potenziale è la modalità con cui si analizzano i dati a disposizione. La tipica analisi ad oggi adottata lavora sui contenuti (strutturati, come abbiamo visto prima), mentre ci sono un mucchio di risposte disponibili analizzando anche il modo con cui questi contenuti sono stati prodotti.

Sto parlando prevalentemente (ma non solo) dell’aggiunta dei social network all’insieme delle base dati disponibili, introducendo il concetto di “sentiment analisys”: si tratta di estrapolare dalle comunicazioni la predisposizione degli autori su determinati concetti, il loro stato emozionale e il concetto che vogliono far passare, per poi raggrupparli e riuscire a definire delle tendenze e degli orientamenti generali, da sfruttare poi nel confronto con la situazione del singolo cliente. Sto parlando anche dell’analisi semantica dei contenuti per poter effettuare valutazioni ad esempio su coerenza e stile: incredibilmente questo aspetto, apparentemente vago e fumoso, è alla base del successo di una compagnia americana che fornisce polizze assicurative, la Infinity Insurance.

Sto parlando prevalentemente (ma non solo) dell’aggiunta dei social network all’insieme delle base dati disponibili, introducendo il concetto di “sentiment analisys”: si tratta di estrapolare dalle comunicazioni la predisposizione degli autori su determinati concetti, il loro stato emozionale e il concetto che vogliono far passare, per poi raggrupparli e riuscire a definire delle tendenze e degli orientamenti generali, da sfruttare poi nel confronto con la situazione del singolo cliente. Sto parlando anche dell’analisi semantica dei contenuti per poter effettuare valutazioni ad esempio su coerenza e stile: incredibilmente questo aspetto, apparentemente vago e fumoso, è alla base del successo di una compagnia americana che fornisce polizze assicurative, la Infinity Insurance.

La soluzione, che prevede il controllo dei dati storici disponibili all’interno della compagnia per identificare dei modelli di comportamento, ha permesso di ridurre enormemente il tempo di analisi delle richieste di rimborsi legati a sinistri. Il risultato è stato ottenuto anche attraverso l’analisi semantica delle relazioni stilate dai richiedenti, individuando sistematicamente all’interno di documenti di migliaia di parole quelle discrepanze (anche piccole) che all’occhio umano potrebbero sfuggire e valutando l’aderenza a modelli identificati come a rischio frode.

Non si riesce ad avere un quadro in maniera immediata della varietà e ampiezza delle possibili applicazioni che i Big Data possono generare, soprattutto considerando la complessità che si portano dietro: è un altro effetto secondario di questi golem dell’informazione.

Facebook Comments