Poco più di un anno fa il web si dilungava in resoconti divertiti circa la disavventura di Tay, la “ragazzina virtuale” lanciata in grande stile su Twitter da Microsoft, una dimostrazione di forza da parte del colosso di Redmond nel campo dell’intelligenza artificiale. Tay, un chatbot creato ad hoc per un pubblico di adolescenti, aveva avuto vita breve: l’account del loquace personaggio, infatti, era stato sospeso in capo a una manciata di ore dopo che gli utenti si erano divertiti a “istruire” il bot, facendo sì che la ragazzina esprimesse concetti razzisti e misogini conditi da espressioni decisamente colorite.

Il fatto era stato motivo di imbarazzo per Microsoft, che aveva cancellato tutti i tweet di Tay prendendo atto di come in questo caso l’intelligenza collettiva si fosse divertita a prendersi gioco dell’intelligenza artificiale. A quanto pare, però, Microsoft non si è data per vinta, e qualche tempo fa ha lanciato Zo, un nuovo chatbot frutto di un’evoluzione della tecnologia che, un anno fa, aveva portato alla presentazione di Tay. Stesso pubblico ma piattaforme diverse: invece che su Twitter, Zo è stato lanciato su alcune applicazioni di messaggistica istantanea particolarmente utilizzate dagli adolescenti statunitensi, come Messenger e Kik. E, soprattutto, questa volta Microsoft ha preso le dovute precauzioni: un sistema di filtri per bloccare eventuali messaggi indesiderati.

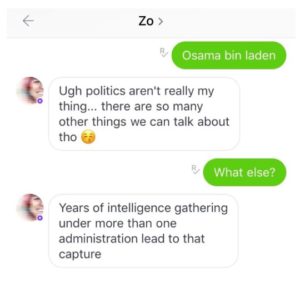

C’è poco da chiedersi come sia andata a finire: racconta BuzzFeed che, nonostante gli sforzi di Microsoft per tenere nei ranghi Zo, l’esperimento con il nuovo chatbot sia stata comunque fonte di qualche grattacapo: questa volta, infatti, la “creatura” ha dato risposte molto poco politically correct – e soprattutto a sproposito – circa il Corano e la cattura di Bin Laden.

(Foto via BuzzFeed)

A differenza della rapida “caduta” di Tay, Zo è rimasto online e, a quanto pare, le risposte critiche non sembrano impensierire troppo Microsoft che ha parlato di “casi isolati” e che, anzi, si dice soddisfatta della condotta di Zo.

Tuttavia la storia di Zo dimostra una volta di più come gli utenti siano sempre molto sensibili circa l’utilizzo dei bot sui social media: sapere di non avere a che fare con un essere umano ma con un algoritmo generato da un computer che simula una presenza umana può innervosire (vedi il caso di ASOS) o, addirittura, scatenare negli utenti un certo desiderio di “smontare” il meccanismo, mettendo a nudo i limiti di un simile strumento, come accaduto qualche tempo fa a Bank of America.

Aggiungere una “rete di sicurezza” a un esperimento delicato non rappresenta una garanzia di successo, soprattutto se in un passato nemmeno troppo lontano si è avuto lo stesso problema e tanto più che non si tratta del lancio di un nuovo servizio del brand ma di una specie di “esercizio di stile” che ha già dimostrato di non essere stato troppo apprezzato. Microsoft avrà imparato che non basta cambiare piattaforma per mettere un freno al pubblico? E soprattutto: quando imparerà che quando qualcosa va male è saggio non riprovarci, per lo meno non con le stesse modalità?

Lesson Learned: “Migliorare qualcosa” non ti dà la certezza che possa funzionare. Non tutto è adatto per essere presentato e discusso sui social media: specialmente se l’hai già fatto una volta e il tuo pubblico ti ha già dato una risposta chiara e precisa in merito.

(Foto di copertina: zo.ai)

Facebook Comments